Computex 2024 – AMD impulsa la innovación y el liderazgo en inteligencia artificial en centros de datos con la hoja de ruta expandida de la GPU AMD Instinct

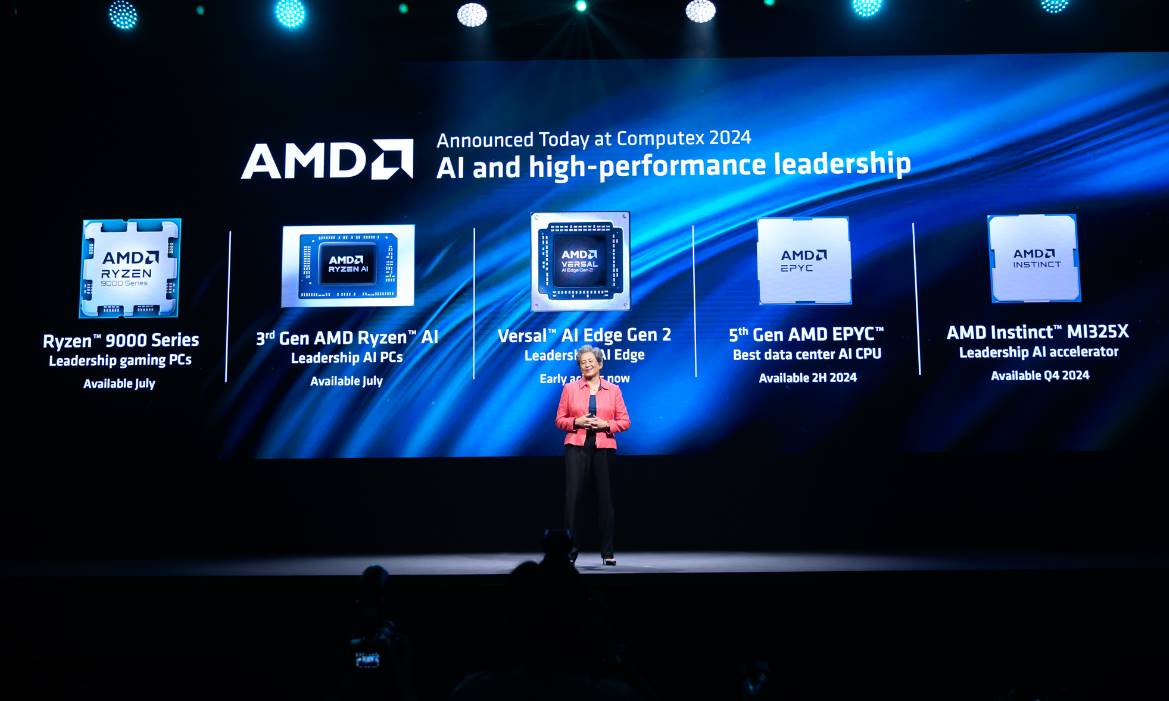

Durante Computex 2024, AMD destacó el progreso continuo de la familia de aceleradores AMD Instinct™ en el discurso inaugural de su presidenta y CEO, la Dra. Lisa Su. AMD reveló una hoja de ruta extendida y a largo plazo para los aceleradores AMD Instinct, prometiendo una actualización anual de las capacidades líderes en rendimiento y memoria para inteligencia artificial con cada nueva generación.

La hoja de ruta actual comienza con el lanzamiento del nuevo acelerador AMD Instinct MI325X, disponible en el último trimestre de 2024. Posteriormente, se anticipa que la Serie AMD Instinct MI350, con la novedosa arquitectura AMD CDNA™ 4, llegará en 2025, ofreciendo un incremento de hasta 35 veces en el rendimiento de inferencia de IA frente a la Serie AMD Instinct MI300 que utiliza la arquitectura AMD CDNA 3. Para 2026, se espera el debut de la serie AMD Instinct MI400, fundamentada en la avanzada arquitectura AMD CDNA «Next».

«Los aceleradores AMD Instinct MI300X continúan su fuerte adopción por parte de numerosos socios y clientes, incluidos Microsoft Azure, Meta, Dell Technologies, HPE, Lenovo y otros, un resultado directo del rendimiento excepcional y la propuesta de valor del acelerador AMD Instinct MI300X», dijo Brad McCredie, vicepresidente corporativo de Data Center Accelerated Compute, AMD. «Con nuestra cadencia anual actualizada de productos, somos implacables en nuestro ritmo de innovación, proporcionando las capacidades de liderazgo y el rendimiento que la industria de la IA y nuestros clientes esperan para impulsar la próxima evolución del entrenamiento y la inferencia de la IA en los centros de datos».

El ecosistema de software de IA de AMD madura

La plataforma de software abierto AMD ROCm™ 6 sigue evolucionando, permitiendo que los aceleradores AMD Instinct MI300X ofrezcan un rendimiento sobresaliente para algunos de los LLM más reconocidos. Con un servidor equipado con ocho aceleradores AMD Instinct MI300X y ROCm 6 ejecutando Meta Llama-3 70B, los clientes pueden experimentar un rendimiento de inferencia y generación de tokens 1.3 veces superior al de la competencia[ii]. Utilizando un único acelerador AMD Instinct MI300X con ROCm 6, se puede lograr un rendimiento de inferencia y generación de tokens 1.2 veces mayor en comparación con la competencia en Mistral-7B[iii]. AMD también resaltó que Hugging Face, el repositorio más extenso y popular de modelos de IA, está verificando 700,000 de sus modelos más destacados cada noche para garantizar su compatibilidad inmediata con los aceleradores AMD Instinct MI300X. Adicionalmente, AMD sigue avanzando en su colaboración con marcos de IA de gran popularidad como PyTorch, TensorFlow y JAX.

AMD presenta nuevos aceleradores y revela su hoja de ruta anual.

En la presentación inaugural, AMD desveló una actualización anual en la hoja de ruta de su acelerador AMD Instinct para responder a la demanda creciente de computación IA más avanzada. Esto asegurará que los aceleradores AMD Instinct sean una fuerza motriz en el desarrollo de los próximos modelos de IA de última generación. La hoja de ruta actualizada anualmente de AMD Instinct resalta:

- El nuevo acelerador AMD Instinct MI325X, que aportará 288 GB de memoria HBM3E y 6 terabytes por segundo de ancho de banda de memoria, utiliza el mismo diseño de servidor de placa base universal estándar de la industria utilizado por la serie AMD Instinct MI300 y estará disponible de forma general en el cuarto trimestre de 2024. El acelerador tendrá una capacidad de memoria y un ancho de banda líderes en la industria, 2 veces y 1.3 veces mejor que la competencia, respectivamente[iv], y un rendimiento informático 1.3 veces mejor[v] que el de la competencia.

- El primer producto de la Serie AMD Instinct MI350, el acelerador AMD Instinct MI350X, se basa en la arquitectura AMD CDNA 4 y se espera que esté disponible en 2025. Utilizará el mismo diseño de servidor de placa base universal estándar de la industria que otros aceleradores de la Serie MI300 y se construirá utilizando tecnología de proceso avanzada de 3 nm, admitirá los tipos de datos de IA FP4 y FP6 y tendrá hasta 288 GB de memoria HBM3E.

- Se espera que la arquitectura AMD CDNA «Next», que impulsará los aceleradores AMD Instinct MI400 Series, esté disponible en 2026 y proporcione las últimas características y capacidades que ayudarán a desbloquear un rendimiento y una eficiencia adicionales para la inferencia y el entrenamiento de IA a gran escala.

Por último, AMD destacó que la demanda de aceleradores AMD Instinct MI300X sigue creciendo con numerosos socios y clientes que utilizan los aceleradores para impulsar sus exigentes cargas de trabajo de IA, entre las que se incluyen:

- Microsoft Azure con los aceleradores para los servicios de Azure OpenAI y las nuevas máquinas virtuales Azure ND MI300X V5.

- Dell Technologies utiliza aceleradores MI300X en PowerEdge XE9680 para cargas de trabajo de IA empresarial.

- Supermicro ofrece múltiples soluciones con aceleradores AMD Instinct.

- Lenovo impulsa la innovación de la IA híbrida con el ThinkSystem SR685a V3.

- HPE los utiliza para acelerar las cargas de trabajo de IA en el HPE Cray XD675.

Conoce más anuncios de IA de AMD Computex aquí y ve una repetición en video de la presentación en la página de YouTube de AMD.

Keynote Completa: